您现在的位置是:首页 > 财经网站首页财经

谷歌大脑研究人员演示如何劫持神经网络

- 编辑:

- 2022-02-15 17:23:23

- 来源:

计算机视觉算法并不完善。就在这个月,研究人员证明了一个流行的物体检测API可能会被误认为是猫的“疯狂被子”和“玻璃纸”。不幸的是,这还不是最糟糕的:他们还可能被迫计算图像中的方块,对数字进行分类,并执行预期任务之外的任务。

在Arxiv.org预印服务器上发表的题为“神经网络的对抗性重编程”的论文中,来自谷歌人工智能研究部门谷歌大脑的研究人员描述了一种对机器学习系统进行实际重编程的对抗性方法。新形式的迁移学习甚至不需要攻击者指定输出。

研究人员写道:“我们的结果(首次证明).可能有对抗神经网络重编程的攻击……”"这些结果证明了深度神经网络惊人的灵活性和脆弱性."

以下是它的工作原理:恶意行为者可以访问正在执行任务的对抗神经网络的参数,然后以转换为输入图像的形式引入干扰或对抗数据。当对抗性输入被输入到网络中时,他们会将所学的功能重新用于新的任务。

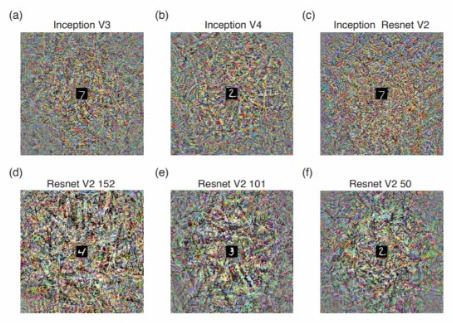

科学家已经在六个模型中测试了这种方法。通过嵌入来自MNIST计算机视觉数据集(黑色框架和白色方块的范围从1到10)的操纵输入图像,他们设法获得所有六种算法来计算图像中的方块数,而不是识别像“白鲨”这样的物体。"鸵鸟"在第二个实验中,他们强迫他们对数字进行分类。在第三次也是最后一次测试中,他们要求模型识别来自CIFAR-10(一个对象识别数据库)的图像,而不是最初训练它们的ImageNet语料库。

不良行为者可以利用攻击窃取计算资源,例如,通过重新编程云托管照片服务中的计算机视觉分类器来解决图像验证码或挖掘加密货币。尽管本文的作者没有在递归神经网络(一种常用于语音识别的网络)中测试这种方法,但他们假设成功的攻击可能会导致这种算法执行“一系列非常大的任务”。

研究人员写道:“对抗程序也可以作为一种新的方法来实现更传统的计算机黑客”。“例如,随着手机越来越多地充当人工智能驱动的数字助理,通过将某人的手机暴露在对立的图像或音频文件中来重新编程的可能性将会增加。因为这些数字助理可以访问用户的电子邮件、日历、社交媒体账户和信用卡,这种攻击的后果将变得更加严重。"

幸运的是,这并不全是坏消息。研究人员指出,随机神经网络似乎比其他神经网络更不容易受到攻击,对抗性攻击可以使机器学习系统更容易重用、更灵活、更高效。

即便如此,他们写道,“未来的调查应该解决对抗性编程的特点和局限性,以及可能的防御方式。